Cel podróży w tym tygodniu ogłoszono nowy model sztucznej inteligencji (AI) koncepcja źródło łączenie wielu typów danych, w tym tekstu, dźwięku, danych wizualnych, odczytów temperatury i ruchu. Model jest w tej chwili tylko projektem badawczym, bez natychmiastowych zastosowań praktycznych lub konsumenckich. Wskazuje jednak na przyszłość systemów generatywną sztuczną inteligencję zdolną do tworzenia wciągających doświadczeń i multisensoryczne. Jego imię to MetaBind obrazu i wyjaśniamy, jak to działa.

Meta wprowadza ImageBind, nowy multisensoryczny model sztucznej inteligencji typu open source. Oto jak to działa i co potrafi

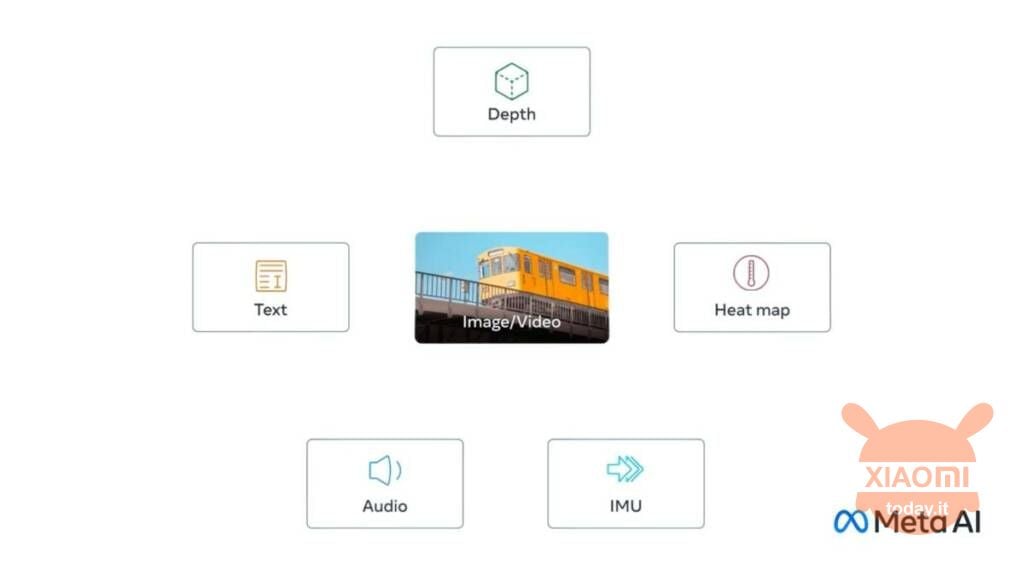

Nowość nazywa się Meta ImageBind i jest pierwszą połączyć sześć typów danych w jedną wielowymiarową przestrzeń. Sześć typów danych zawartych w modelu to:

- Wizualizacje (w postaci obrazów i filmów)

- Termiczne (obrazowanie w podczerwieni)

- test

- Audio

- Szczegółowe informacje

- Odczyty ruchu generowane przez inercyjną jednostkę pomiarową lub IMU

Zobacz także: Meta wprowadza SAM, sztuczną inteligencję, która identyfikuje poszczególne elementy w obrazach

Chodzi o to, że przyszłe systemy AI mogą to zrobić powiązać te dane w ten sam sposób, w jaki obecne systemy służą do wprowadzania tekstu. Wyobraź sobie na przykład futurystyczne urządzenie rzeczywistości wirtualnej, które generuje nie tylko dane wejściowe audio i wizualne, ale także nasze otoczenie i nasz ruch na fizycznej scenie. Użytkownik może poprosić narzędzie o to naśladować długą podróż morską, i nie tylko umieściłby go na statku z szumem fal w tle, ale także kołyszącym się pokładem pod stopami i chłodną bryzą oceanicznego powietrza. Pomysł polega na tym, że platforma łączy różne formaty danych w celu wygenerowania wyniku.

W poście na blogu Meta zauważa to można dodać inne sensoryczne strumienie wejściowe do przyszłych modeli, w tym „dotyku, mowy, węchu i sygnałów mózgowych fMRI„. Ta nowo wydana funkcja nie jest jeszcze gotowa, więc społeczność nie może jej przetestować na tak wczesnym etapie, mimo że jest na zaawansowanym etapie rozwoju.